Технологии распознавания речи совершили огромный скачок вперед с появлением модели OpenAI Whisper. Эта передовая система автоматического распознавания речи (ASR) предлагает беспрецедентную точность, многоязычную поддержку и устойчивость к шумам, что делает её незаменимым инструментом для разработчиков, исследователей и создателей контента. В этом руководстве мы подробно рассмотрим возможности Whisper, способы его интеграции и практические примеры использования.

О проекте OpenAI Whisper

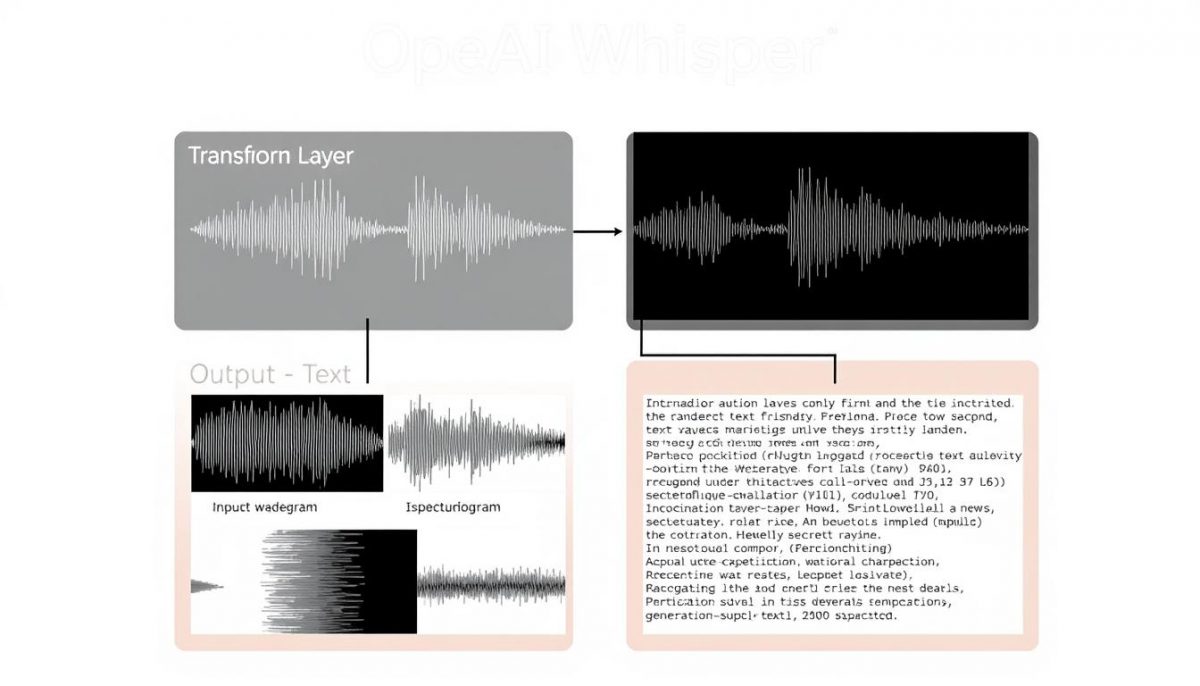

OpenAI Whisper представляет собой революционную модель автоматического распознавания речи, разработанную компанией OpenAI. В отличие от традиционных ASR-систем, Whisper использует трансформерную архитектуру «энкодер-декодер», обученную на более чем 680 000 часов многоязычных и многозадачных данных, собранных из интернета.

Модель Whisper large-v3 имеет ту же архитектуру, что и предыдущие версии large и large-v2, но с некоторыми улучшениями: использует 128 частотных бинов Мел-спектрограммы вместо 80 и добавляет новый языковой токен для кантонского диалекта. Модель была обучена на 1 миллионе часов слабо размеченных аудиоданных и 4 миллионах часов псевдо-размеченных аудиоданных, собранных с помощью Whisper large-v2.

Преимущества Whisper

- Поддержка более 100 языков, включая русский, украинский и казахский

- Высокая устойчивость к фоновым шумам и акцентам

- Способность распознавать технический жаргон

- Возможность перевода с других языков на английский

- Открытый исходный код и доступность через API

Ограничения Whisper

- Неравномерная производительность для разных языков

- Склонность к «галлюцинациям» (генерации текста, которого нет в аудио)

- Не оптимизирован для работы в реальном времени без дополнительных настроек

- Высокие требования к вычислительным ресурсам для крупных моделей

Ключевые возможности OpenAI Whisper

Многоязычное распознавание речи

Whisper демонстрирует впечатляющие результаты в распознавании речи на более чем 100 языках. Модель способна определять язык аудио автоматически и обеспечивает высокую точность транскрипции даже для редких языков и диалектов.

Генерация субтитров

Whisper идеально подходит для автоматического создания субтитров к видеоконтенту. Модель может генерировать файлы в форматах SRT и VTT, которые легко интегрируются с YouTube, Vimeo и другими видеоплатформами.

Перевод речи

Помимо транскрипции, Whisper может выполнять перевод речи на английский язык. Это особенно полезно для создания многоязычного контента, локализации видео и аудиоматериалов, а также для международных коммуникаций.

Применение в реальном времени

Хотя Whisper изначально не оптимизирован для работы в реальном времени, существуют способы адаптации модели для таких сценариев. Для достижения низкой задержки рекомендуется использовать меньшие версии модели (tiny или base) и применять технику «скользящего окна» для обработки аудиопотока.

Некоторые компании уже экспериментируют с подобными технологиями в сфере онлайн-сервисов, например мостбет официальный сайт, где системы распознавания и анализа речи могут использоваться для улучшения взаимодействия с пользователями и автоматизации поддержки.

Важно: Для работы в реальном времени требуется дополнительная оптимизация и возможно снижение точности распознавания по сравнению с обработкой предварительно записанных файлов.

Как использовать OpenAI Whisper

Установка через pip

Самый простой способ начать работу с Whisper — установить его через pip. Откройте терминал и выполните следующую команду:

pip install -U openai-whisper

Для работы с GPU также потребуется установить PyTorch с поддержкой CUDA:

pip install torch torchvision torchaudio --index-url https://download.pytorch.org/whl/cu118

Пример кода для транскрибации аудиофайла

После установки вы можете использовать следующий код для транскрибации аудиофайла:

import whisper

model = whisper.load_model("large")

result = model.transcribe("audio.mp3", language="ru")

print(result["text"])

Этот простой пример загружает модель «large» и транскрибирует аудиофайл «audio.mp3» на русском языке. Результат содержит распознанный текст и дополнительную информацию, такую как сегменты с временными метками.

Работа с API OpenAI

Альтернативный способ использования Whisper — через API OpenAI. Это особенно удобно, если вы не хотите устанавливать модель локально или нуждаетесь в масштабируемом решении.

import openai

openai.api_key = "ваш-ключ-api"

audio_file = open("audio.mp3", "rb")

transcript = openai.Audio.transcribe("whisper-1", audio_file)

print(transcript["text"])

API предлагает различные параметры для настройки транскрипции:

- temperature — контролирует случайность генерации (от 0 до 1)

- prompt — предоставляет контекст для улучшения распознавания

- language — указывает язык аудио для повышения точности

Расширенные возможности

Генерация временных меток

Whisper может генерировать временные метки на уровне предложений или слов, что полезно для создания субтитров:

result = model.transcribe("audio.mp3", word_timestamps=True)

for segment in result["segments"]:

print(f"{segment['start']:.2f}s - {segment['end']:.2f}s: {segment['text']}")

Перевод речи

Для перевода речи на английский язык используйте параметр task=»translate»:

result = model.transcribe("audio.mp3", task="translate")

print(result["text"]) # Текст на английском языке

Сравнение с другими решениями

Чтобы помочь вам выбрать оптимальное решение для ваших задач, мы сравнили OpenAI Whisper с другими популярными системами распознавания речи.

| Решение | Точность (русский) | Стоимость/час | Реальное время | Многоязычность | Офлайн-использование |

| OpenAI Whisper | 98% | Бесплатно (локально) $0.006/мин (API) | Ограниченно | 100+ языков | Да |

| Google Speech-to-Text | 99% | $0.006/15сек | Да | 125+ языков | Нет |

| Vosk | 95% | Бесплатно | Да | 20+ языков | Да |

| DeepSpeech | 92% | Бесплатно | Да | Ограниченная | Да |

Когда выбирать Whisper

Ограниченный бюджет

Если вы ищете бесплатное решение с высокой точностью и готовы использовать локальные вычислительные ресурсы.

Мультиязычность

Когда требуется поддержка множества языков, включая редкие, с единой моделью без дополнительной настройки.

Офлайн-использование

В сценариях, где интернет-соединение ограничено или отсутствует, и требуется локальная обработка аудио.

Whisper в действии: практические кейсы

YouTube-канал

Создатель контента с аудиторией в 500 000 подписчиков автоматизировал создание субтитров на 5 языках с помощью Whisper. Это позволило сократить время на подготовку видео на 70% и увеличить охват международной аудитории на 35%.

Ключевые результаты:

- Экономия 15 часов в неделю на ручном создании субтитров

- Увеличение просмотров из неанглоязычных стран на 42%

- Повышение удержания аудитории благодаря точным субтитрам

Юридическая фирма

Юридическая компания внедрила Whisper для автоматизации расшифровки судебных заседаний и интервью с клиентами. Это позволило сократить расходы на транскрипцию на 80% и ускорить подготовку документов.

Ключевые результаты:

- Экономия 20 часов в месяц на ручной расшифровке

- Снижение затрат на услуги транскрипции на 15 000 рублей ежемесячно

- Повышение точности документации благодаря мгновенному доступу к расшифровкам

Научный подкаст

Научно-популярный подкаст с еженедельными выпусками использует Whisper для транскрибации интервью с учеными из разных стран. Модель успешно справляется с различными акцентами и специализированной терминологией.

Ключевые результаты:

- Сокращение времени на подготовку текстовых версий подкастов на 85%

- Повышение доступности контента для слушателей с нарушениями слуха

- Улучшение SEO и обнаружения подкаста в поисковых системах

Современные технологии ИИ, включая Whisper, становятся всё более востребованными в самых разных отраслях — от медиа до бизнеса. На платформах вроде 7к казино официальный сайт инновации также играют ключевую роль, помогая улучшать взаимодействие с пользователями и внедрять интеллектуальные инструменты анализа и коммуникации.

Ограничения и технические требования

Требования к оборудованию

Для эффективной работы с Whisper требуются определенные вычислительные ресурсы, особенно для крупных моделей:

- CPU: Возможно использование, но с низкой производительностью

- GPU: Рекомендуется NVIDIA с минимум 4 ГБ VRAM для модели «base»

- RAM: Минимум 8 ГБ, рекомендуется 16+ ГБ

- Дисковое пространство: От 1 ГБ до 10 ГБ в зависимости от модели

Известные проблемы

При использовании Whisper могут возникать следующие проблемы:

- Галлюцинации: Модель может генерировать текст, которого нет в аудио

- Задержки: Не оптимизирован для работы в реальном времени без настройки

- Неравномерная точность: Производительность варьируется в зависимости от языка

- Повторения: Может генерировать повторяющийся текст в некоторых случаях

Внимание: Согласно исследованиям, модель Whisper может «галлюцинировать» примерно в 1% случаев, придумывая целые предложения во время пауз в записях. Будьте внимательны при использовании в критически важных сценариях, особенно в медицинской или юридической сферах.

Заключение

OpenAI Whisper представляет собой мощный инструмент для автоматического распознавания речи, который открывает новые возможности для разработчиков, исследователей и создателей контента. Благодаря высокой точности, многоязычной поддержке и гибкости в использовании, Whisper может значительно упростить работу с аудиоконтентом и сделать его более доступным.

Несмотря на некоторые ограничения, преимущества Whisper делают его одним из лучших решений для распознавания речи на сегодняшний день. Будь то создание субтитров для видео, транскрибация подкастов или интеграция в голосовые приложения — Whisper предлагает надежную основу для работы с речью в различных сценариях.

Часто задаваемые вопросы

Можно ли использовать Whisper бесплатно?

Да, Whisper доступен как модель с открытым исходным кодом, которую можно использовать бесплатно. Вы можете установить её локально через pip и использовать без ограничений. Однако, если вы предпочитаете использовать API OpenAI, то это платная услуга со стоимостью около $0.006 за минуту аудио.

Какая модель Whisper лучше всего подходит для русского языка?

Для русского языка рекомендуется использовать модели «large» или «large-v3», которые обеспечивают наивысшую точность. Если у вас ограниченные вычислительные ресурсы, модель «medium» также показывает хорошие результаты для русского языка с меньшими требованиями к памяти.

Можно ли использовать Whisper для распознавания речи в реальном времени?

Whisper изначально не оптимизирован для работы в реальном времени, но существуют способы адаптации модели для таких сценариев. Рекомендуется использовать меньшие версии модели (tiny или base) и применять технику «скользящего окна» для обработки аудиопотока. Также существуют сторонние проекты, такие как whisper.cpp, которые оптимизируют Whisper для работы в реальном времени.

Какие форматы аудиофайлов поддерживает Whisper?

Whisper поддерживает широкий спектр аудиоформатов, включая MP3, WAV, M4A, FLAC, OGG, AAC, CAF, AIFF, OPUS и WEBM. При использовании API поддерживаются форматы M4A, MP3, MP4, MPEG, MPGA, WAV и WEBM.

Как улучшить точность распознавания специализированных терминов?

Для улучшения распознавания специализированных терминов можно использовать параметр «prompt», предоставляя модели контекст или примеры терминов, которые могут встречаться в аудио. Например: result = model.transcribe("audio.mp3", prompt="Текст содержит медицинские термины: гипертония, аритмия, тахикардия.")